Les méandres méta-analytiques

A quoi sert une méta-analyse ? Pourquoi est-il si difficile de conclure à l’existence ou non d’un effet ? Dans cet article, nous décrirons rapidement l’histoire de la méta-analyse, sa recette ainsi que ses limites… quitte à vous perdre dans ces méandres !

En 1946, le Docteur Américain Benjamin Spock publie son méga best-seller : « The Common Sense Book of Baby and Child Care » (traduit en 1952 sous le titre « Comment soigner et éduquer son enfant »). Dans cet ouvrage, vendu à plus de 50 millions d’exemplaires, le Dr. Spock prodigue de nombreux conseils pour les futurs ou jeunes parents quant à la manière de gérer les besoins nutritionnels, affectifs et cognitifs de leurs poupons. Parmi la multitude d’astuces, il précise qu'il est préférable d'habituer l’enfant à dormir sur le ventre dès le début s'il le souhaite – une recommandation typique des pédiatres de l’époque.

Entre les années 1950 et 1990, plus de 100 000 nourrissons décèdent de mort subite en grande majorité à cause de cette position de sommeil ventral favorisant le risque d'étouffement. Depuis les années 1970, les risques de cette position étaient connus mais les autorités ont attendu les années 1990 pour réactualiser leurs recommandations. En 2005, Ruth Gilbert et ses collègues de l’Institut de la Santé Infantile de Londres indiquent dans une révision systématique de 2005 que :

« Les conseils visant à endormir les nourrissons sur le ventre pendant près d'un demi-siècle étaient contraires aux preuves disponibles dès 1970 selon lesquelles cela pouvait être néfaste. Un examen systématique des facteurs de risque évitables de la mort subite du nourrisson à partir de 1970 aurait conduit à une reconnaissance plus précoce des risques de dormir sur le ventre et aurait pu éviter plus de 10000 décès de nourrissons au Royaume-Uni et au moins 50000 en Europe, aux États-Unis et en Australasie » (Gilbert et coll., 2005).

L'objectif de la méta-analyse est de combiner, de résumer et d’analyser toutes les données disponibles relatives à un domaine de recherche ou à une question de recherche clairement définis (Lipsey & Wilson, 2001). L'estimation correcte des moyennes d'un effet est un problème ancien, qui remonte à l'époque babylonienne où l'on cherchait à estimer les mouvements du soleil et des planètes. Au fil des siècles, des astronomes comme Ptolémée, Brahe et Lagrange ont développé des théories mathématiques pour minimiser les erreurs d'observations. Dès le IIIe siècle avant JC, les Babyloniens tentaient d’estimer les mouvements du soleil, de la lune et des autres planètes – en témoignent des tablettes en craie de cette même époque (Neugebauer, 1951 ; Plackett, 1958).

Bien que notre connaissance de l’astronomie mésopotamienne soit quasi nulle, les textes astronomiques de l’époque obtenus semblent indiquer qu’ils sont une des premières civilisations à s’atteler au problème. Par la suite, l'astronome britannique Sir George Airy (1861) a proposé une méthode pour traiter l'accumulation des erreurs de mesures dans les données recueillies, qui a inspiré le statisticien Karl Pearson (1904) à réaliser la première méta-analyse appliquée à la santé. Pearson a ainsi conclu que le vaccin contre la fièvre typhoïde devait être amélioré (Shannon, 2016).

La recette méta-analytique

Depuis l’époque de Pearson, des efforts considérables ont été faits pour combiner de manière systématique les données d’études sur le même sujet, en développant notamment une base de données nommée Cochrane (rassemblant des données de haute qualité pour aider les décisions en politique de santé publique), aujourd’hui largement citée dans le monde entier (https://www.cochranelibrary.com/). De telles initiatives contribuent à regrouper et ainsi mettre à disposition de larges résultats méta-analytiques.

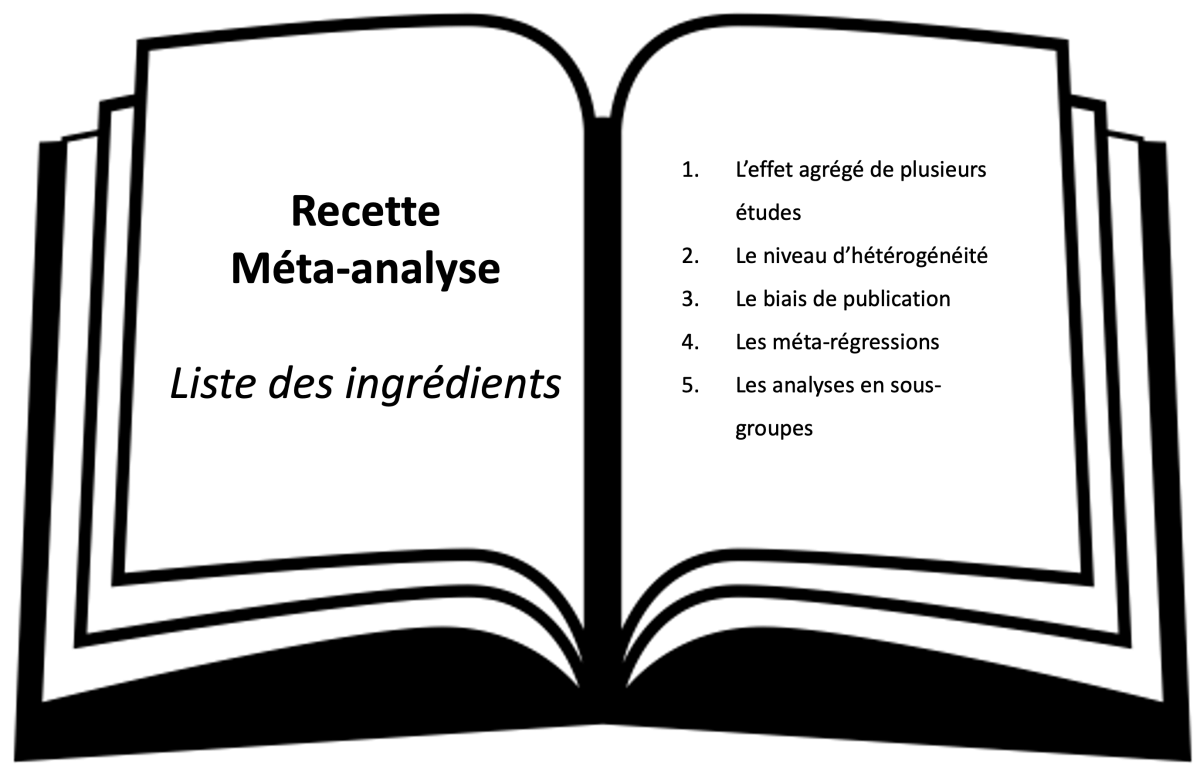

La recette de la méta-analyse inclue toujours les mêmes ingrédients (Borenstein et coll., 2021 ; Card, 2015 ; Lipsey & Wilson, 2001 ; Schwarzer et coll., 2015) :

- L’effet agrégé (c’est-à-dire la combinaison) de plusieurs études (par exemple, le taux de mortalité de patients covid-19 exposés ou non à un médicament particulier) ;

- Le niveau d’hétérogénéité (les études diffèrent dans leurs résultats à cause de différences entre les patients, les posologies du médicament, les durées des études, etc.) ;

- Le biais de publication (c’est-à-dire la surreprésentation des études ayant trouvé un effet du médicament comparées à celles qui n’en ont pas trouvé) ;

- Les analyses statistiques qui permettent de contrôler l'effet des caractéristiques des études (par exemple, les caractéristiques de l'étude, les procédures, les mesures) et de l'échantillon (par exemple, l'âge, le sexe, l’indice de masse corporelle, l'historique médical) en les comparant entre des groupes plus restreints d'études.

Lorsqu’un chercheur décide d’intégrer un groupe d’études dans une méta-analyse, il suppose que les études sont suffisamment semblables pour qu’il fasse sens de les réunir, bien qu’il n’y ait généralement aucune raison de supposer qu’elles soient identiques (Almaatouq et coll., 2022 ; Borenstein et coll., 2021). On évalue donc l'hétérogénéité en comparant l'effet de chaque étude à l’effet agrégé de toutes les études. Si l'hétérogénéité est trop importante, on peut diviser les études en sous-groupes pour voir si les effets diffèrent. Par exemple, Horowitz et Garber (2006) observent que lorsqu’ils « méta-analysent » des actions de prévention de la dépression chez des enfants et des adolescents, des actions ciblées (sur des élèves plus à risques de faire une dépression) reportaient des effets 2 à 3 fois plus forts que des approches sur l’ensemble des élèves. Cela signifie que la prévention de la dépression peut être efficace chez les enfants et adolescent en général, mais qu'elle est bien plus efficace chez ceux à risque (Werner Seidler et coll., 2021). Il est donc fondamental d’évaluer et de comprendre la source de cette hétérogénéité.

Les limites des méta-analyses

Il faut garder à l’esprit que les méta-analyses restent un outil statistique dont les résultats dépendent de l’usage qu’en fait le chercheur. De légères déviations dans les hypothèses de départ peuvent donner des résultats très différents comme en témoignent les deux méta-analyses publiées en parallèle de Kelly Gildersleelve et ses collèges de UCLA dans la revue Psychological Bulletin (2014a) et de Wendy Wood et ses collègues de l’Université de Californie du Sud dans la revue Emotion Review (2014).

L’idée de départ est relativement simple : ils ont remarqué que pendant l'ovulation, les femmes pouvaient être plus attirées par des partenaires qui ont des traits génétiques avantageux (comme la symétrie faciale ou la masculinité du corps) mais que ce changement de préférence durant le cycle ne se manifeste que pour des relations à court-terme. Leur méta-analyse, réunissant 50 études, indiquent effectivement que les femmes reportent être significativement plus attirées par des critères ancestraux de qualité génétique chez des partenaires masculins pour des relations à court-terme mais pas pour des relations à long-terme.

En parallèle, un groupe de chercheurs de la même ville, dirigé par Wendy Wood, publie une méta-analyse qui ne trouve aucun effet du cycle menstruel sur les critères de préférence (pour l’anecdote, l’auteure principale était d’ailleurs associée à la première méta-analyse avant qu’elle ne se retire finalement pour faire la sienne…). Comment est-il possible que deux méta-analyses sur la même thématique trouvent des résultats différents ? Christine Harris de l’Université de Californie à San Diego, et ses collègues, publient une lettre à l’éditeur de la revue Psychological Bulletin (2014) pour critiquer la méta-analyse de Kelly Gildersleeve et collaboratrices (c’est une pratique courante de réagir à une publication récente).

Harris soutient que la littérature sur le cycle menstruel est victime d’un grand degré de liberté des chercheurs dans le calcul du nombre de jours fertiles/non fertiles, les critères d’exclusion des participants entre autres choses. Cette flexibilité dans la conceptualisation, la mise en place, l’analyse ou le report des résultats représente un grand risque (sinon le principal risque) en méthodologie puisqu’il diminue la confiance dans les résultats reportés (Hohn et coll., 2020 ; Simmons et coll., 2011). D’autres champs de la psychologie se sont enlisés dans cette « méta-guerre » où les méta-analyses n’arrivent pas, par exemple, à trancher le débat sur l’effet des jeux vidéo dans les conduites agressives, les potentiels bénéfices de l’éducation positive ou encore la relation entre antidépresseurs et suicide (de Vrieze, 2018).

Pour répondre à ces accusations, Gildersleeve et ses collègues (2014b) proposent d’utiliser un outil statistique nommé p-curve pour essayer de détecter si certaines études ont effectivement été manipulées et ne trouve pas d’évidences en faveur de cette hypothèse. On s’est récemment rendu compte que même la p-curve est un outil très sensible à l’hétérogénéité et à la manipulation des données et des analyses. Depuis, de nombreuses techniques statistiques se développent pour déterminer les risques associés aux biais de publications, mais aussi des techniques qualitatives qui consistent à lire les articles avec des guides d’observations, comme préconisé par Cochrane (ROB2).

De nos jours, des collaborations internationales permettent de répliquer des études de haute qualité pour ensuite les agréger. Une comparaison entre les méta-analyses et ce genre de réplication indique bien une surestimation de 3 fois la taille d’effet réel dans les méta-analyses ce qui indiquerait que ces dernières sont encore victimes de nombreux biais. Une raison de plus pour s’assurer que les études inclues dans les méta-analyses soient de bonne qualité, et d’éviter le fait qu’inclure une étude de mauvaise qualité dans une méta-analyse réduise la qualité du résultat de la méta-analyse.

Références

Airy, G. B. (1861). On the algebraical and numerical theory of errors of observations and the combination of observations. Macmillan and co.

Almaatouq, A., Griffiths, T. L., Suchow, J. W., Whiting, M. E., Evans, J., & Watts, D. J. (2022). Beyond playing 20 questions with nature: Integrative experiment design in the social and behavioral sciences. Behavioral and Brain Sciences, 1-55. https://doi.org/10.1017/S0140525X22002874

Borenstein, M., Hedges, L. V., Higgins, J. P., & Rothstein, H. R. (2021). Introduction to meta-analysis. John Wiley & Sons.

Card, N. A. (2015). Applied meta-analysis for social science research. Guilford Publications

de Vrieze J. (2018). The metawars. Science, 361, 1184–1188.

Gilbert, R., Salanti, G., Harden, M., & See, S. (2005). Infant sleeping position and the sudden infant death syndrome: Systematic review of observational studies and historical review of recommendations from 1940 to 2002. International Journal of Epidemiology, 34(4), 874-887. https://doi.org/10.1093/ije/dyi088

Gildersleeve, K., Haselton, M. G., & Fales, M. R. (2014a). Do women’s mate preferences change across the ovulatory cycle? A meta-analytic review. Psychological Bulletin, 140(5), 1205–1259. https://doi.org/10.1037/a0035438

Gildersleeve, K., Haselton, M. G., & Fales, M. R. (2014b). Meta-analyses and p-curves support robust cycle shifts in women’s mate preferences: Reply to Wood and Carden (2014) and Harris, Pashler, and Mickes (2014). Psychological Bulletin, 140(5), 1272–1280. https://doi.org/10.1037/a0037714

Harris, C. R., Pashler, H., & Mickes, L. (2014). Elastic analysis procedures: An incurable (but preventable) problem in the fertility effect literature. Comment on Gildersleeve, Haselton, and Fales (2014). Psychological Bulletin, 140(5), 1260–1264. https://doi.org/10.1037/a0036478

Hohn, R. E., Slaney, K. L., & Tafreshi, D. (2020). An empirical review of research and reporting practices in psychological meta-analyses. Review of General Psychology, 24(3), 195-209. https://doi.org/10.1177/1089268020918844

Horowitz, J. L., & Garber, J. (2006). The prevention of depressive symptoms in children and adolescents: A meta-analytic review. Journal of Consulting and Clinical Psychology, 74(3), 401–415. https://doi.org/10.1037/0022-006X.74.3.401

Lipsey, M. W., & Wilson, D. B. (2001). Practical meta-analysis. SAGE publications, Inc.

Neugebauer, O. (1951). The Babylonian method for the computation of the last visibilities of Mercury. Proceedings of the American Philosophical Society, 95(2), 110-116.

Pearson, K. (1904). Report on certain enteric fever inoculation statistics. BMJ, 3, 1243–1246.

Plackett, R. L. (1958). Studies in the history of probability and statistics: VII. The principle of the arithmetic mean. Biometrika, 45(1-2), 130-135. https://doi.org/10.1093/biomet/45.1-2.130

Schwarzer, G., Carpenter, J. R., & Rücker, G. (2015). Meta-analysis with R. Cham.

Shannon, H. (2016). A statistical note on Karl Pearson’s 1904 meta-analysis. Journal of the Royal Society of Medicine, 109(8), 310-311. https://doi.org/10.1177%2F0141076816659003

Simmons, J. P., Nelson, L. D., & Simonsohn, U. (2018). False-positive citations. Perspectives on Psychological Science, 13(2), 255-259. https://doi.org/10.1177/1745691617698146

Spock, B. (1946). The Common Sense Book of Baby and Child Care. Duell, Sloan and Pearce.

Werner-Seidler, A., Spanos, S., Calear, A. L., Perry, Y., Torok, M., O'Dea, B., ... & Newby, J. M. (2021). School-based depression and anxiety prevention programs: An updated systematic review and meta-analysis. Clinical Psychology Review, 89, 102079, 1-24. https://doi.org/10.1016/j.cpr.2021.102079

Wood, W., Kressel, L., Joshi, P. D., & Louie, B. (2014). Meta-analysis of menstrual cycle effects on women’s mate preferences. Emotion Review, 6(3), 229-249. https://doi.org/10.1177/1754073914523073