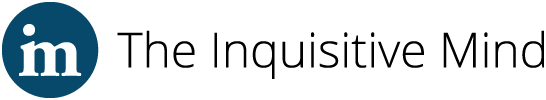

Science ouverte et crise de confiance vis-à-vis de la science

Depuis maintenant une dizaine d’années, la psychologie, et la science en général, font l’objet d’une crise de confiance qui se traduit par une remise en question de la crédibilité accordée aux chercheurs et aux résultats des recherches scientifiques. Nous verrons que l’adoption des pratiques de science ouverte peut, dans une certaine mesure, être une solution à cette crise de confiance.

Aux origines de la crise de confiance

En mars 2011, un article de Daryl Bem (un psychologue social connu et reconnu) est publié dans le prestigieux Journal of Personality and Social Psychology (JPSP). Cet article, intitulé « Feeling the future : experimental evidence for anomalous retroactive influences on cognition and affect », présente une série de 9 expériences qui, selon l’auteur, prouvent l’existence de l’énergie psi et de la précognition (c’est-à-dire la connaissance implicite du futur !). Pour sa démonstration, Bem a inversé la chronologie d’expériences ou de phénomènes classiques de psychologie (priming sémantique, comportements d’approche/évitement, habituation, facilitation du rappel par la répétition) et, données et tests statistiques à l’appui, il présente des effets rétroactifs (dit autrement, les réponses de l'individu sont obtenues avant même que les stimuli supposés être la cause de ces réponses ne se produisent). Il explique ces effets rétroactifs par la capacité de l’être humain à « ressentir le futur ». Par exemple, dans l’expérience 1 de son article, Bem demande à des participants de deviner derrière lequel des deux rideaux affichés sur un écran d’ordinateur se trouve une photo. Les résultats présentés indiquent que les participants réussissent à deviner où se trouve la photo dans 53,1% des cas (un taux supérieur à ce qui serait prédit par le hasard), tout au moins quand la photo en question est considérée comme désirable (photo érotique). Peut-on pour autant conclure que nous sommes capables de pressentir le futur ?

À la suite d’un communiqué de presse enthousiaste publié par l’université de Cornell en janvier 2011 (et retiré depuis), l’article de Bem a fait couler beaucoup d’encre, et ce pour plusieurs raisons. Tout d’abord, il prétend donner des preuves de notre capacité à prédire le futur, et l’idée de l’existence de pouvoirs extrasensoriels, apparaisse séduisante ou farfelue, qui ne laisse pas indifférent. Ainsi, avant même sa publication effective dans le JPSP, l’article de Bem a fait l’objet de billets ou d’articles dans des médias et blogs scientifiques (par ex. New Scientist, Discover, Wired) et dans certains journaux grand public (par ex. dans les colonnes du New York Times ; Carey, 2011). Mais la raison principale pour laquelle l’article de Bem (2011) est aujourd’hui célèbre en psychologie est que l’analyse approfondie qui en a été faite a mis sous le feu des projecteurs un certain nombre de pratiques de recherche dites « discutables » présentes – notamment, mais pas uniquement – dans certaines études de psychologie.

Si l’article de Bem était conforme aux plus hauts standards scientifiques de l’époque (ce qui explique pourquoi il a passé l’épreuve de l’évaluation par les pairs ; pour information, le JPSP est très sélectif et a un taux de rejet des articles soumis de plus de 85 %), un examen minutieux des études par la communauté scientifique a fait émerger de nombreuses critiques. Au-delà du caractère discutable de l’utilisation de certains tests statistiques, ce serait surtout la flexibilité méthodologico-analytique (c’est-à-dire le fait de choisir, parmi les méthodes et outils disponibles, ceux qui maximisent la probabilité de trouver des résultats plutôt que la robustesse des résultats ; Gelman & Loken, 2013) et le cumul de pratiques de recherche discutables (LeBel & Peters, 2011) qui auraient permis à Bem de conclure de manière fausse à l’existence de l’énergie Psi[1]. Les débats qui ont entouré la publication de l’article de Bem ont eu au moins deux retombées importantes. La première, négative, concerne l’image de la psychologie sociale. La seconde, positive, porte sur l’engagement d’une réflexion sur les standards et les pratiques de recherche, ainsi que leur nécessaire évolution.

Des causes à la crise de confiance : biais de publication et pratiques de recherche discutables

Quelles sont les pratiques de recherche discutables et leurs conséquences ? Un premier problème, identifié de longue date, est le biais de publication, le « file drawer problem » (Ferguson & Brannick, 2012 ; Rosenthal, 1979). Ce biais correspond au fait que seules les recherches qui mettent en évidence des résultats statistiquement significatifs sont publiées, alors que les autres (une majorité) restent dans les tiroirs. La psychologie étant une science probabiliste, sélectionner les études dont les résultats sont significatifs tout en ignorant les études dont les résultats sont nuls peut amener à publier des recherches dont les résultats sont le simple fruit du hasard (autrement dit, des faux positifs). Par conséquent, à travers le prisme du biais de publication, la littérature scientifique nous fournit une vision déformée ou tout au moins incomplète de l’état de la recherche. Si l’on revient à l’exemple de Bem, les 9 études publiées font partie d’un ensemble bien plus important d’études sur le sujet (comme il le dira à demi-mot à Engber, 2017), mais qui sont restées dans le tiroir car elles ne « marchaient pas » (autrement dit, car elles ne mettaient pas en évidence d’effets statistiquement significatifs). Le problème du biais de publication peut être mis en lien avec le célèbre « publier ou périr » (publish or perish), qui renvoie au fait que les universitaires sont essentiellement évalués sur leur capacité à publier, donc à obtenir des études qui produisent des résultats significatifs. La pression à la publication (pour obtenir ou conserver un poste académique, progresser dans sa carrière, obtenir des financements de recherche…) a dans certains cas pu motiver des chercheurs à adopter des pratiques de recherche discutables, mais qui augmentaient leurs chances d’avoir des résultats et donc de publier.

Si certaines pratiques discutables peuvent relever d’une mauvaise connaissance ou interprétation des statistiques (Nickerson, 2000), par exemple à travers l’utilisation d’échantillons trop petits (ce qui crée un manque de puissance statistique et a pour conséquences 1) d’augmenter la probabilité de faux négatifs lorsque l’effet est vrai dans la population, mais aussi 2) de faciliter le p-hacking et donc la proportion de faux positifs en ajoutant ou retirant quelques participants par exemple ; voir entre autres Bakker et coll., 2012 ; Fraley & Vazire, 2014), d’autres pratiques sont moins excusables ou éthiquement justifiables (tout au moins au regard des normes actuelles). C’est le cas de différentes pratiques qui renvoient à ce que l’on appelle le p-hacking (Masicampo & Lalande, 2012), c’est-à-dire des techniques liées à la méthode ou aux statistiques que les chercheurs peuvent utiliser pour augmenter les chances de trouver des résultats significatifs (autrement dit d’obtenir une p-valeur < .05, ce qui constitue le seuil considéré comme la norme pour conclure à la présence d’un effet). Les méthodes de p-hacking sont en fait assez nombreuses. On trouve par exemple le test régulier des hypothèses et l’arrêt de la collecte des données une fois que les résultats attendus sont obtenus (data-peeking), des règles d’exclusion des participants floues ou déterminées après coup et qui permettent de ne conserver que les données allant dans le sens des attentes (cherry picking) ou encore l’ajout ou la suppression de variables supplémentaires (covariées) jusqu’à réussir à obtenir un résultat significatif. Parmi les pratiques problématiques, on peut aussi citer la formulation des hypothèses une fois les résultats obtenus (le HARKing : Hypothesizing After the Results are Known ; Kerr, 1998) ou encore le fait que certains résultats et leur contraire puissent être interprétés comme soutenant l’hypothèse (voir Wagenmakers et coll., 2011).

Certaines des méthodes citées ci-dessus faisaient partie des pratiques de recherche de Bem pour son article de 2011. Par exemple, il y a eu un changement de procédure au cours de l’expérience 1 après que 40 des 100 participants sont passés (ce qui rend les choses non comparables) ; certains tests statistiques ont été utilisés plutôt que d’autres ; des hypothèses présentées comme confirmatoires (déduites de la littérature existante) semblent plutôt de nature exploratoire (formulées après l’observation des données), etc. Précisons que Bem n’est pas un cas isolé. En 2011, dans une enquête menée auprès de 2000 chercheurs en psychologie (John et coll., 2012), près de la moitié admettaient avoir eu recours à une ou plusieurs des pratiques de recherche discutables citées plus haut. Au-delà des considérations éthiques, les pratiques de recherche discutables ne sont pas sans conséquences pour la science dans la mesure où elles augmentent de manière importante la probabilité de faux positifs (Simmons et coll., 2011) et conduisent donc à la publication de résultats scientifiquement douteux.

Les débats sur les pratiques de recherche et leurs conséquences se sont traduits par la publication de nombreux articles sur les méthodes et les statistiques (Finkel et coll., 2015 ; Simmons et coll., 2011) et ont donné lieu à des recommandations à destination de la communauté scientifique : les « nouvelles pratiques de recherche ». Ces réflexions ont également contribué à l’accélération du développement de la science ouverte (Open Science ; LeBel et coll., 2017).

Réplications, nouvelles pratiques de recherche et science ouverte : améliorer la crédibilité de la psychologie en rendant les recherches plus transparentes

La conjonction de la mise en évidence des pratiques de recherche discutables, de leurs conséquences, et de la révélation de cas de fraudes (voir l’affaire Diederik Stapel[2]) a entraîné une crise de confiance sans précédent vis-à-vis des résultats des recherches passées et présentes (Engber, 2017). Ceci a poussé certains chercheurs à vouloir vérifier que les résultats de recherches classiques de psychologie pouvaient être répliqués. La réplication (c’est-à-dire le fait de reproduire à l’identique une recherche pour voir si les mêmes résultats sont obtenus) est en soi une nécessité et fait partie intégrante du processus d’administration de preuve et du principe cumulatif de la science : répliquer un résultat renforce sa crédibilité et permet de tester sa robustesse. Pourtant, avant 2011, publier une réplication n’était ni aisé (puisque jugé dans le système de publication comme n’apportant pas quelque chose de nouveau aux connaissances), ni valorisé au sein de la communauté des chercheurs.

Dans l’objectif de tester la réplicabilité des effets en psychologie, de grands programmes internationaux ont été lancés. Plus précisément, l’idée était de re-tester une sélection d’expériences classiques publiées dans trois journaux de haut niveau en suivant les standards des nouvelles pratiques de recherche. Les plus connus de ces programmes de réplication sont le Reproducibility Project (Open Science Collaboration, 2012) et les Many Labs initiés par Brian Nosek (Klein et coll., 2014). Ces programmes de réplication, en impliquant de nombreux chercheurs et laboratoires, permettent aussi de récolter des données sur des échantillons importants (souvent plusieurs milliers de participants), ce qui augmente la puissance statistique et limite les risques de faux positifs. Pour augmenter la transparence et permettre de futures réplications ou des analyses complémentaires, le matériel utilisé pour l’étude (Open material) et les fichiers de données et les analyses effectuées (Open data) sont également rendus disponibles sur une plateforme accessible à tous : l’Open Science Framework (voir Klein et coll., 2018, pour une discussion autour de ces aspects et un guide pratique d’application des principes de transparence et de science ouverte en psychologie).

Rapidement, toujours dans l’idée de rendre les recherches les plus transparentes possibles, les études de réplication font la plupart du temps aussi l’objet d’un pré-enregistrement. Cette procédure consiste à déposer sur un site (par ex. aspredicted.org ou osf.io), avant le début de la collecte des données, l’ensemble des éléments qui vont permettre de supprimer ou limiter les pratiques de recherche discutables. Ainsi, le fait de pré-enregistrer précisément les hypothèses qui vont être testées évite le HARKing ; la présentation exhaustive des variables qui seront utilisées ou manipulées évite la sélection après coup de « ce qui fonctionne » ; le fait de préciser avant le début de la recherche les règles de collecte des données et d’exclusion prévient le cherry picking ; la détermination de la taille de l’échantillon nécessaire pour mettre en évidence l’effet attendu permet une bonne puissance statistique ; le fait de préciser les tests statistiques prévus pour tester les hypothèses limite le p-hacking, etc.

Les résultats des programmes de réplication ont montré que, souvent, seulement environ 50 % des effets rapportés ont été répliqués avec succès, ce qui vient renforcer l’idée qu’une partie des résultats publiés dans les articles pré-2011 sont peut-être des faux positifs liés à des pratiques de recherche discutables, mais aussi qu’il est nécessaire, pour la psychologie et les autres sciences, d’être transparents tant sur les hypothèses testées que sur les méthodes, le matériel et les conditions de réalisation de l’étude.

Conclusion

La psychologie et la science en général, font depuis quelques années l’objet d’une crise de confiance[3] : confiance dans les résultats, confiance dans les chercheurs, confiance dans les publications… Comme nous l’avons vu, du fait de certaines pratiques de recherche discutables, cette perte de confiance ne manque pas de fondement. La réflexion engagée sur les pratiques de recherche, leur transparence et la qualité/crédibilité des recherches plus anciennes n’est donc pas dénuée de sens. Le mouvement de science ouverte, qui donne aux recherches un maximum de transparence, et l’adoption des nouvelles pratiques de recherches, qui visent à promouvoir des méthodes plus sûres, peuvent apporter un début de réponse à la crise de crédibilité. On voit également se développer des mouvements centrés sur l’amélioration de la recherche dans les sciences psychologiques (par ex., la Society for the Improvement of Psychological Science) ou les réflexions autour de la Slow science (Frith, 2020).

Si les choses évoluent positivement, elles évoluent cependant assez lentement. Des éléments laissent cependant penser que ces pratiques et la science ouverte deviendront bientôt la norme plutôt que l’exception. Par exemple, un nombre de plus en plus important de revues scientifiques ont modifié leurs consignes aux auteurs pour inclure des éléments tels que le pré-enregistrement des études (voir l’article d’Anthony Lantian dans ce numéro thématique) ou le calcul de puissance a priori (pour une introduction, voir l’épisode 1 de la série Stats to the point de l’ADRIPS). Les supports de publication se transforment aussi parallèlement à ces nouvelles pratiques et recommandations. On assiste ainsi à la multiplication des supports de publication en Open Access (par exemple la Revue Internationale de Psychologie Sociale ; voir à ce propos l’article d’Alexandra Masciantonio dans ce numéro) et le développement rapide des Registered Reports, de nouveaux types d’articles pour lesquels des recherches acceptées sur la base d’un pré-enregistrement sont publiées, quels que soient les résultats obtenus.

On peut également se réjouir de la place prise désormais par les plateformes permettant la Science Ouverte à travers le partage des pré-enregistrements, du matériel, et des données (Open Science Framework et ses équivalents), l’augmentation du nombre des méta analyses (voir l’article de Jordane Boudesseul dans ce numéro) et le développement et l’utilisation de techniques d’estimation du p-hacking telles que les analyses de p-curves (Simonsohn et coll., 2014) ou de Z-curves (Brunner & Schimmack, 2020). On saluera enfin les initiatives telles que le Psychological Science Accelerator ou les Collaborative Replications and Education Project (voir l’article de Ribotta et coll. dans ce numéro thématique) qui favorisent la formation des étudiants à l’open science et aux nouvelles pratiques dans le cadre de projets internationaux multi-labos. Gageons qu’à travers l’adoption des nouvelles pratiques et des principes de science ouverte, les résultats des recherches en psychologie (re)gagneront en crédibilité.

Notes de fin

1 : Sur la base des pratiques ayant mené aux résultats de l’article de Bem (2011), Simmons et coll. (2011) ont montré que la flexibilité dans la collecte et l’analyse des données pouvait permettre de présenter à peu près n’importe quoi comme un résultat significatif... comme faire rajeunir des participants après leur avoir fait écouter « When I’m 64 » des Beatles.

2 : Le 7 septembre 2011, l’Université de Tilburg déclare que Diederik Stapel, Professeur de psychologie sociale et cognitive, est suspendu de ses fonctions pour fraude(s). Les conclusions de l’enquête de trois comités font état de nombreux cas de fabrication de données. A ce jour, 58 articles de Stapel ont fait l’objet d’une rétractation (source : www.retractionwatch.com)

3 : Les débats autour du Covid et des vaccins peuvent en être une illustration récente.

Références

Bakker, M., Van Dijk, A., & Wicherts, J. M. (2012). The rules of the game called psychological science. Perspectives on Psychological Science, 7(6), 543-554. https://doi.org/10.1177/1745691612459060

Bem, D. J. (2011). Feeling the future: Experimental evidence for anomalous retroactive influences on cognition and affect. Journal of Personality and Social Psychology, 100(3), 407. https://doi.org/10.1037/a0021524

Brunner, J., & Schimmack, U. (2020). Estimating population mean power under conditions of heterogeneity and selection for significance. Meta-Psychology, 4. https://doi.org/10.15626/mp.2018.874

Carey, B. (2011). You might already know this. The New York Times, 10. https://www.nytimes.com/2011/01/11/science/11esp.html

Engber, D. (2017). Daryl Bem proved ESP is real: Which means science is broken. Slate, May, 17. https://slate.com/health-and-science/2017/06/daryl-bem-proved-esp-is-real-showed-science-is-broken.html

Ferguson, C. J., & Brannick, M. T. (2012). Publication bias in psychological science: Prevalence, methods for identifying and controlling, and implications for the use of meta-analyses. Psychological Methods, 17(1), 120. https://doi.org/10.1037/a0024445

Finkel, E. J., Eastwick, P. W., & Reis, H. T. (2015). Best research practices in psychology: Illustrating epistemological and pragmatic considerations with the case of relationship science. Journal of Personality and Social Psychology, 108(2), 275. https://doi.org/10.1037/pspi0000007

Fraley, R. C., & Vazire, S. (2014). The N-pact factor: Evaluating the quality of empirical journals with respect to sample size and statistical power. PloS one, 9(10), e109019. https://doi:10.1371/journal.pone.0109019

Frith, U. (2020). Fast lane to slow science. Trends in Cognitive Sciences, 24(1), 1-2. https://doi.org/10.1016/j.tics.2019.10.007

Gelman, A., & Loken, E. (2013). The garden of forking paths: Why multiple comparisons can be a problem, even when there is no “fishing expedition” or “p-hacking” and the research hypothesis was posited ahead of time. Department of Statistics, Columbia University, 348, 1-17. http://stat.columbia.edu/~gelman/research/unpublished/forking.pdf

John, L. K., Loewenstein, G., & Prelec, D. (2012). Measuring the prevalence of questionable research practices with incentives for truth telling. Psychological Science, 23(5), 524-532. https://doi.org/10.1177/0956797611430953

Kerr, N. L. (1998). HARKing: Hypothesizing after the results are known. Personality and Social Psychology Review, 2(3), 196-217. https://doi.org/10.1207/s15327957pspr0203_4

Klein, O., Hardwicke, T. E., Aust, F., Breuer, J., Danielsson, H., Mohr, A. H., ... & Frank, M. C. (2018). A practical guide for transparency in psychological science. Collabra: Psychology, 4(1), 20. https://doi.org/10.1525/collabra.158

Klein, R. A., Ratliff, K. A., Vianello, M., Adams, R. B., Jr., Bahník, Š., Bernstein, M. J., Bocian, K., Brandt, M. J., Brooks, B., Brumbaugh, C. C., Cemalcilar, Z., Chandler, J., Cheong, W., Davis, W. E., Devos, T., Eisner, M., Frankowska, N., Furrow, D., Galliani, E. M., . . . Nosek, B. A. (2014). Investigating variation in replicability: A “many labs” replication project. Social Psychology, 45(3), 142–152. https://doi.org/10.1027/1864-9335/a000178

LeBel, E. P., Campbell, L., & Loving, T. J. (2017). Benefits of open and high-powered research outweigh costs. Journal of Personality and Social psychology, 113(2), 230. https://doi.org/10.1037/pspi0000049

LeBel, E. P., & Peters, K. R. (2011). Fearing the future of empirical psychology: Bem's (2011) evidence of psi as a case study of deficiencies in modal research practice. Review of General Psychology, 15(4), 371-379. https://doi.org/10.1037/a0025172

Masicampo, E. J., & Lalande, D. R. (2012). A peculiar prevalence of p values just below. 05. The Quarterly Journal of Experimental Psychology, 65(11), 2271-2279. https://doi.org/10.1080/17470218.2012.711335

Nickerson, R. S. (2000). Null hypothesis significance testing: A review of an old and continuing controversy. Psychological Methods, 5(2), 241. https://doi.org/10.1037/1082-989x.5.2.241

Open Science Collaboration. (2012). An open, large-scale, collaborative effort to estimate the reproducibility of psychological science. Perspectives on Psychological Science, 7, 657-660. https://doi.org/10.1177/1745691612462588

Rosenthal, R. (1979). The ‘file drawer problem’ and tolerance for null results. Psychological Bulletin, 86, 638–641. https://doi.org/10.1037/0033-2909.86.3.638

Simmons, J. P., Nelson, L. D., & Simonsohn, U. (2011). False-positive psychology: Undisclosed flexibility in data collection and analysis allows presenting anything as significant. Psychological Science, 22(11), 1359–1366. https://doi.org/10.1177/0956797611417632

Simonsohn, U., Nelson, L. D., & Simmons, J. P. (2014). P-curve: A key to the file-drawer. Journal of Experimental Psychology: General, 143(2), 534–547. https://doi.org/10.1037/a0033242

Wagenmakers, E. J., Wetzels, R., Borsboom, D., & Van Der Maas, H. L. (2011). Why psychologists must change the way they analyze their data: The case of psi: Comment on Bem (2011). https://doi.org/10.1037/a0022790